La opinión pública ante la inteligencia artificial: conocimiento, expectativas y regulación

Fecha: junio 2024

María Miyar Busto*

Inteligencia artificial, Opinión pública, Confianza, Regulación

Panorama Social, N.º 39 (junio 2024)

Este artículo indaga en aspectos fundamentales del conocimiento y uso sociales de la inteligencia artificial en España, y expone asimismo datos sobre la confianza hacia esta tecnología, el alcance de sus implicaciones y la regulación que se considera más apropiada. Se utilizan para ello datos de una encuesta online realizada por Funcas a finales de 2023 a una muestra de 1.000 personas entre 25 y 64 años. Los resultados destacan que el conocimiento y uso de la inteligencia artificial en España es aún limitado, pero más frecuente, al igual que las actitudes positivas, entre los hombres jóvenes. En todos los grupos de edad, sexo, nivel educativo, conocimiento y uso de la inteligencia artificial analizados se observa una preferencia mayoritaria por una regulación de la IA más orientada al control de los riesgos que al fomento del desarrollo competitivo de esta tecnología.

1. INTRODUCCIÓN

A lo largo de la historia, la adopción de nuevas tecnologías ha dependido en gran medida de la respuesta social a las innovaciones. Después de todo, la tecnología no avanza en un vacío; su éxito depende de cómo la sociedad la perciba y comprenda. La inteligencia artificial (IA), como última frontera tecnológica, no es una excepción. A medida que la IA se integra en diversos aspectos de la vida cotidiana, desde la salud hasta el entretenimiento, se hace evidente que las actitudes y la confianza en ella son cruciales para su adopción y regulación. El recientemente publicado AI index 2024 annual report de la Universidad de Stanford (Maslej et al., 2024) destaca no solo el creciente reconocimiento global de la importancia de la IA, sino también el aumento del nerviosismo por sus posibles consecuencias. Además, dada la complejidad específica del desarrollo de la IA, el conocimiento sobre su funcionamiento y sobre cómo utilizarla eficazmente se convierten en factores cruciales de su implementación.

Este artículo examina los elementos fundamentales del conocimiento, el uso y la confianza en la IA en España, así como las prioridades respecto al marco regulativo, utilizando datos de una encuesta online realizada por Funcas a finales de 2023 a una muestra de 1.000 personas entre 25 y 64 años. Se presentan aquí los principales resultados de esta encuesta, que constituye una de las primeras evidencias empíricas en España sobre cómo se posiciona la población ante la IA después del lanzamiento del disruptivo ChatGPT en noviembre de 2022 y de diversos modelos de lenguaje a gran escala (LLM, por sus siglas en inglés), que han acercado a la población general la potencialidad de la inteligencia artificial1.

De la capacidad de la IA para transformar numerosos aspectos de la vida diaria y profesional se desprende la necesidad de que la sociedad la comprenda y conozca. Al fin y al cabo, el conocimiento adecuado de la IA permite a las personas tomar decisiones informadas sobre su uso y maximizar sus beneficios. Esto incluye, por ejemplo, mejorar la eficiencia en el trabajo mediante la automatización de tareas repetitivas, o personalizar los procesos educativos para atender mejor las necesidades individuales. Pero, además, la IA tiene el potencial de mejorar la toma de decisiones en la vida diaria, desde la crianza de los hijos y la salud hasta la gestión del hogar: la potencial optimización del bienestar personal atañe a dimensiones muy variadas. Entender y utilizar la IA de manera efectiva implica una mejor adaptación a los cambios tecnológicos que moldean el entorno.

Por supuesto, y como se puede deducir de lo anterior, la falta de conocimiento sobre el uso de la IA puede acarrear significativas consecuencias sociales negativas. La carencia de una comprensión adecuada de esta tecnología aumenta la vulnerabilidad ante su uso indebido y ante la desinformación. Además, un uso ineficiente de la IA implicaría el desaprovechamiento de recursos y oportunidades de mejora. Asimismo, la falta de habilidades para manejar la IA puede agravar las desigualdades digitales, dejando a ciertos grupos aún más rezagados en un mundo progresivamente tecnológico. En definitiva, es fundamental que el conjunto de la sociedad tenga un conocimiento sólido sobre la IA para maximizar sus beneficios y minimizar sus riesgos. Este conocimiento, como muchos otros, ni es inmediato ni se puede dar por supuesto. Al igual que desarrollamos nuestras habilidades cognitivas a través del aprendizaje y el esfuerzo, se puede esperar que la experiencia con la IA mejore la eficiencia en su utilización.

Cabe señalar que, incluso aunque estén dispuestas a utilizar la IA, muchas personas manifiestan su desconfianza hacia ella (Liehner et al., 2023). No debería sorprender el recelo hacia la IA si se tiene en cuenta que su aplicación a distintas tareas entraña riesgos significativos. Algunos son nuevos para la sociedad, pero no todos. Como ante otras revoluciones tecnológicas, los cambios en la demanda de empleo y la desigualdad económica ocupan un lugar central en la preocupación de muchos sociólogos y economistas, ya que la IA puede dejar obsoletas muchas tareas mientras concentra riqueza y poder en manos de quienes controlan estas tecnologías. Otras amenazas hacen referencia a riesgos para la seguridad, la perpetuación de sesgos si los sistemas de IA utilizan datos defectuosos, o las violaciones de la privacidad debido a la necesidad que estos sistemas tienen de ingentes cantidades de datos. También surgen problemas éticos en áreas como la salud, la justicia penal y las armas autónomas, en las que las decisiones de la IA pueden impactar significativamente la vida humana. La difusión de desinformación a través de contenido generado por IA, como los deepfakes, plantea retos adicionales. La consideración conjunta de las magnitudes de estos riesgos y beneficios da cuenta del enorme reto que implica diseñar una regulación de la IA que fomente su desarrollo a la vez que proteja a la sociedad de su mal uso.

Por supuesto, la regulación de la IA en un país o en una región determinada no es independiente de las características de la sociedad que ha de cumplirla. Sirvan de ejemplo las diferencias en la regulación de la IA entre Estados Unidos y Europa, que reflejan los distintos climas de opinión pública, cultura y valores predominantes en cada región. En Europa, prevalece la determinación por establecer regulaciones en nombre de la seguridad, la privacidad y la protección de los datos personales. En todo caso, las recientes iniciativas comunitarias para evitar el cifrado de extremo a extremo de forma que se pueda acceder a las comunicaciones durante investigaciones criminales apuntan a que la balanza de la prioridad regulatoria en Europa se inclina más hacia la seguridad que hacia la privacidad2. Por su parte, Estados Unidos adopta un enfoque mucho más liberal en la regulación de la IA, priorizando la innovación y el desarrollo tecnológico sobre la normativa. Esta regulación más laxa permite a las empresas experimentar y crecer con menos restricciones, fomentando un entorno más dinámico y competitivo. Refleja, también, una cultura que valora especialmente la libertad empresarial, la flexibilidad y la rapidez de los avances tecnológicos. No obstante, este enfoque liberal no está exento de críticas, que señalan la falta de protecciones adecuadas para la privacidad. En definitiva, mientras Europa avanza con un enfoque más cauteloso y regulador, Estados Unidos sigue un camino más liberal y menos restrictivo. China, por otro lado, practica una aproximación centralizada y autoritaria, utilizando la tecnología para fortalecer el control estatal y la vigilancia masiva; una estrategia que, por lo demás, se corresponde con una cultura política que prioriza la estabilidad social y el control gubernamental sobre la libertad individual y la privacidad.

Con el objetivo de analizar la percepción social de la IA en el contexto español, este artículo se estructura de la siguiente manera. Tras explicar brevemente la evolución de la IA para contextualizar el momento actual, en el que se va tomando conciencia global del potencial impacto para la humanidad, el tercer apartado presenta las principales teorías y evidencias sobre los determinantes de la percepción social de las nuevas tecnologías, con un enfoque particular en la IA. A continuación, en el cuarto apartado, se estudia el conocimiento y uso de la inteligencia artificial en España. En el quinto se analizan las distintas dimensiones que reflejan las expectativas negativas que la IA puede generar en la sociedad. A la explicación, en el sexto apartado, de algunos hallazgos sobre la postura de la sociedad española ante la regulación de la IA y su percepción acerca de quién está liderando esta tecnología en la carrera internacional le siguen unas breves conclusiones.

2. La IA ni ha nacido ahora, ni ha alcanzado aún la madurez

La conciencia pública sobre el impacto de la IA ha crecido significativamente desde el lanzamiento en octubre de 2022 de ChatGPT, una aplicación que utiliza un Modelo de Lenguaje de Gran Escala (LLM, por sus siglas en inglés) de la compañía OpenAI. Este modelo permite interactuar con la tecnología de manera natural y efectiva, haciendo mucho más accesible para la sociedad general la comprensión del potencial impacto de la IA en la vida diaria. Los últimos años de la década de 2010 y, especialmente, los primeros de la década de 2020 han sido testigo de una explosión de herramientas basadas en IA accesibles para el gran público. Estas herramientas representan avances significativos en diversas tareas. Entre ellas se incluyen la traducción de textos (DeepL), la edición de textos (Grammarly), la generación de imágenes (MidJourney, DALL-E), la creación de contenido escrito (Jasper), la asistencia en programación (GitHub Copilot), la mejora de la productividad en aplicaciones de oficina (Microsoft Copilot), las funciones avanzadas para videoconferencias y reuniones virtuales (Zoom), y las herramientas de diseño gráfico asistidas por IA (Canva). Además, la IA ha impulsado avances significativos en campos menos visibles para el público general, como la atención médica, donde se utiliza para diagnósticos y tratamientos personalizados, y en la defensa, con tecnologías que mejoran la seguridad y la vigilancia. Estos desarrollos no solo demuestran la capacidad de la IA para aumentar la productividad, sino que también hacen que esta tecnología sea más tangible y relevante para el público general.

En todo caso, la IA no es un concepto nuevo. Sus raíces se remontan a ideas filosóficas antiguas sobre autómatas y seres artificiales, aunque el desarrollo moderno comenzó en el siglo XX. Se suele citar el Test de Turing, planteado en 1950, como el hito que sentó las bases para la IA moderna. Este test proponía que si una máquina podía engañar a un humano haciéndole creer que también era humana, entonces podía considerarse inteligente. La Conferencia de Dartmouth, celebrada en 1956, reunió a un grupo de investigadores para explorar la posibilidad de crear máquinas inteligentes y marcó el nacimiento oficial de la IA como disciplina académica. Durante esos años, los investigadores desarrollaron programas que podían resolver problemas matemáticos y jugar al ajedrez, aunque sus capacidades eran aún bastante limitadas. En las décadas de 1970 y 1980 el interés y la financiación disminuyeron ante las dificultades para superar algunos desafíos técnicos, como la falta de capacidad computacional y la complejidad del lenguaje natural. A pesar de ello, incluso en esas décadas –en ocasiones referidas como “el invierno de la IA”– se produjeron avances como los de los “sistemas expertos”, que lograron éxitos reseñables, por ejemplo en la medicina, al imitar la toma de decisiones de expertos humanos.

Avances tecnológicos y teóricos en los años noventa contribuyeron al renacimiento de la IA. Un hito importante (y mediático) ocurrió en 1997, cuando Deep Blue de IBM venció al campeón mundial de ajedrez Garry Kasparov. En esa década, el aprendizaje automático comenzó a ganar protagonismo, permitiendo a las computadoras aprender y mejorar con la experiencia, y dando lugar a exitosas aplicaciones para el reconocimiento de voz y la visión por computadora.

Pero es ya en el siglo XXI cuando la humanidad ha asistido a una explosión en el desarrollo y la aplicación de la IA, impulsada por el big data y el aprendizaje profundo (deep learning). Este último, inspirado en la estructura y función del cerebro humano, ha permitido progresos muy significativos en reconocimiento de imágenes, procesamiento del lenguaje natural y otros campos. Según el AI index 2024 annual report, en 2023 la IA ha logrado superar el rendimiento humano en varias áreas, como la clasificación de imágenes, el razonamiento visual y la comprensión del inglés. Empresas tecnológicas como Google, Facebook y Amazon han integrado la IA en productos y servicios cotidianos, como asistentes virtuales que utilizan técnicas avanzadas para interactuar con los usuarios. Particularmente relevante para la opinión pública ha sido el desarrollo de los LLM. Estos modelos han revolucionado la interacción con la IA, permitiendo generar textos coherentes a partir de grandes cantidades de datos.

A medida que la IA continúa evolucionando, el desarrollo de una inteligencia artificial general (AGI, por sus siglas en inglés) se está convirtiendo en un tema de gran interés y debate. La AGI se refiere a una IA que puede igualar o superar la inteligencia humana en todas las tareas, no solo en ámbitos específicos. Este tipo de IA tendría la capacidad de aprender y adaptarse de manera autónoma, abriendo posibilidades sin precedentes, pero también planteando (nuevos) desafíos éticos y de seguridad. Investigadores y futuristas han propuesto diversos escenarios futuros para la AGI, que varían desde utopías en las que la tecnología resuelve problemas globales y mejora significativamente la calidad de vida, hasta distopías en las que la IA podría exacerbar desigualdades, eliminar empleos y, en el peor de los casos, volverse incontrolable. Entre estos expertos ha destacado Ray Kurzweil (2015), que ha desarrollado el argumento sobre la “singularidad”, un punto hipotético en el futuro en el que el crecimiento tecnológico se vuelve incontrolable y cambia, irreversiblemente y de forma impredecible, la sociedad humana. Kurzweil y otros teóricos sugieren que la singularidad podría alcanzarse alrededor de 2045, aunque esta fecha es especulativa y depende de numerosos factores tecnológicos y sociales.

Nick Bostrom, otro influyente pensador en el campo de la IA y la singularidad, examina en su libro Superintelligence: Paths, dangers, strategies (2014) los posibles escenarios en los que la AGI podría surgir y las implicaciones éticas y de seguridad que conllevaría. Bostrom advierte sobre los riesgos existenciales que la AGI podría representar para la humanidad si no se gestionan adecuadamente y aboga por una planificación proactiva para asegurar que el desarrollo de la IA se alinee con los intereses humanos.

3. ¿Cómo se moldea la percepción social de la IA?

Muchas veces la relación entre sociedad y tecnología se ha interpretado desde un punto de vista determinista, según el cual la tecnología se desarrolla de manera autónoma y afecta a la sociedad unilateralmente. Sin embargo, es importante reconocer la interacción entre la sociedad y la tecnología, como señalan Sartori y Bocca (2023), y poner de relieve que diversos factores sociales también moldean el desarrollo y, sobre todo, el uso de la tecnología.

Las investigaciones de carácter teórico sobre la interacción entre sociedad y tecnología se han fijado especialmente, aunque no solo, en los determinantes de la adopción de nuevas tecnologías. De hecho, este es un tema ampliamente estudiado y conceptualizado por diversos modelos teóricos. Entre los más destacados se encuentra el Modelo de Aceptación Tecnológica (TAM, por sus siglas en inglés), desarrollado por Fred Davis en 1989 (Davis y Granić, 2024), de acuerdo con el cual la adopción de una tecnología depende significativamente de la percepción social de su utilidad. La facilidad de uso también es crucial para Davis: las tecnologías intuitivas y que requieren poco esfuerzo de aprendizaje y uso se adoptan más rápidamente. Estos factores influyen en la actitud hacia el uso de la tecnología, que, a su vez, afecta a la intención de uso y a su uso efectivo. Además, la confianza en la tecnología y en sus proveedores es esencial. En este sentido, aspectos como la privacidad de los datos, la seguridad y la transparencia de los sistemas de IA adquieren importancia en la implantación de la tecnología.

Dando un paso más allá, la Teoría Unificada de Aceptación y Uso de Tecnología (UTAUT), propuesta por Venkatesh en 2003 integra elementos de varias teorías anteriores y destaca cuatro constructos clave: la expectativa de rendimiento, la expectativa de esfuerzo, la influencia social y las condiciones facilitadoras (Venkatesh, 2022). Se consideran aquí la edad y el género como variables moderadoras, junto con la experiencia y la voluntariedad de uso. Por su parte, y poniendo el foco en los usuarios, la Teoría de la Difusión de Innovaciones (DOI), propuesta por Everett Rogers en 1962, constituye un marco teórico que explica cómo las nuevas ideas, prácticas o productos se propagan a través de diferentes canales de comunicación a lo largo del tiempo entre los miembros de un mismo sistema social (Rogers, 2004). Esta teoría ha sido ampliamente utilizada y estudiada en diversas disciplinas académicas, como la salud pública, la tecnología de la información, la educación y la gestión de la innovación. Rogers clasificó a los adoptantes de una innovación en cinco categorías definidas en función de su disposición y capacidad para adoptar nuevas ideas: “los innovadores” son los primeros en adoptar, asumiendo riesgos y con acceso a recursos financieros y técnicos; “los adoptadores tempranos” son líderes de opinión que influyen en la difusión de la innovación; “la mayoría temprana” adopta la innovación después de comprobar su eficacia; le sigue “la mayoría tardía”, más escéptica; finalmente, “los rezagados” son los últimos en adoptar una tecnología debido a su aversión al cambio.

Un concepto especialmente relevante en cuanto a la IA es el de los imaginarios socio-técnicos (Sartori y Bocca, 2023). Definidos como visiones colectivas y estables de futuros deseables, estos imaginarios juegan un papel crucial en la forma en que la sociedad percibe y organiza la tecnología. Por ejemplo, Cave y Dihal (2019) destacan cómo la imaginación colectiva, influida por narrativas tanto ficticias como reales, juega un papel significativo en la formación del discurso sobre la IA. Estos imaginarios incluyen tanto esperanzas idealistas como temores que las personas proyectan sobre estas tecnologías. Liehner et al. (2023) también subrayan el papel de las utopías y las distopías al poner de relieve cómo, de hecho, la confianza y la intención de uso se relacionan con la creencia en un mundo peligroso y con el optimismo tecnológico.

Más allá de las dimensiones directamente relacionadas con la tecnología, el conocimiento y la aceptación de la IA dependen de factores relativos a las sociedades en que se implantan. Diversos estudios han mostrado la influencia de distintas variables sociodemográficas en las actitudes y la confianza respecto a la IA. Por ejemplo, el nivel educativo se ha relacionado positivamente con una visión más favorable de la IA (Tyso y Kikuchi, 2023), mientras que la edad se ha señalado como un factor que influye negativamente en el conocimiento y el interés por esta tecnología (Sánchez-Holgado et al., 2022). La revisión que Zhang (2022) hace de varias encuestas en diversos contextos internacionales concluye que las mujeres y los individuos de menor estatus socioeconómico suelen presentar menores niveles de confianza hacia la IA. En una revisión de otros estudios, también Jermutus et al. (2022) encuentran una menor propensión de las mujeres a confiar en la inteligencia artificial. Este resultado es muy frecuente en los trabajos empíricos sobre la percepción social de la IA. Entre los más recientes figuran los del Pew Research (Tyson y Kikuchi, 2023), el AI index 2024 annual report (Maslej, 2024) y, con datos españoles de 2022, los procedentes de la Encuesta de Percepción Social de la Ciencia y la Tecnología en España (FECYT, 2023).

Las investigaciones indican que, aunque la sociedad está cada vez más informada sobre la IA, para sectores cuantitativamente significativos la comprensión sobre ella aún es vaga (Merenkov et al., 2021; Vogels, 2023) y, de hecho, las dificultades para estimar sus beneficios y riesgos la convierten en una especie de “caja negra” (Brauner et al., 2023). También en campos específicos (y críticos) como la defensa, la investigación empírica ha revelado importantes malentendidos en el conocimiento que tiene la población general (Hadlington et al., 2024).

El contexto social y cultural, en todo caso, juega un papel fundamental en la respuesta de la sociedad a la IA. Por ejemplo, las personas de Asia Oriental presentan niveles de confianza relativamente altos (Zhang, 2022). También, por ejemplo, Yigitcanlar et al. (2023) señalan que los australianos son menos propensos que los hongkoneses a valorar la utilidad de la IA en la mejora de los servicios gubernamentales locales. En todo caso, la preocupación por los riesgos de la IA se halla muy presente en análisis empíricos desarrollados en contextos tan diferentes como China (Mao y Shi-Kupfer, 2023), Reino Unido (Crockett et al., 2020) o Italia (Sartori y Bocca, 2023).

La confianza pública en la IA también varía significativamente según la aplicación específica. Así lo señalan, para el Reino Unido, Crockett et al. (2020), que encuentran diferentes niveles de confianza en las aplicaciones de IA según sus usos, con niveles de confianza mayores para IA en aplicaciones como dispositivos domésticos inteligentes, y menores en áreas como la legislación o las armas autónomas. Incluso en su aplicación a un mismo ámbito como el de la medicina, las actitudes difieren en función del tipo de tarea (Beets et al., 2023). También, investigaciones como las de Zimmer et al. (2021) han señalado cómo el público, en general, prefiere que las decisiones médicas las tome el personal sanitario, aun cuando considera más probable que tales decisiones, en comparación con las que podría generar la IA, adolezcan de sesgos culturales. Análisis realizados con datos de Estados Unidos encuentran evidencias similares (Tyson et al., 2023). Esta postura ambivalente se manifiesta también en cuanto a la opinión sobre la aplicación de la IA a las artes (Brewer et al., 2024): el apoyo a su uso puede convivir con la creencia de que provocará la desaparición de empleos, una de las preocupaciones más citadas respecto a la IA (Marken y Nicola, 2023).

4. Quién conoce y usa la IA en España

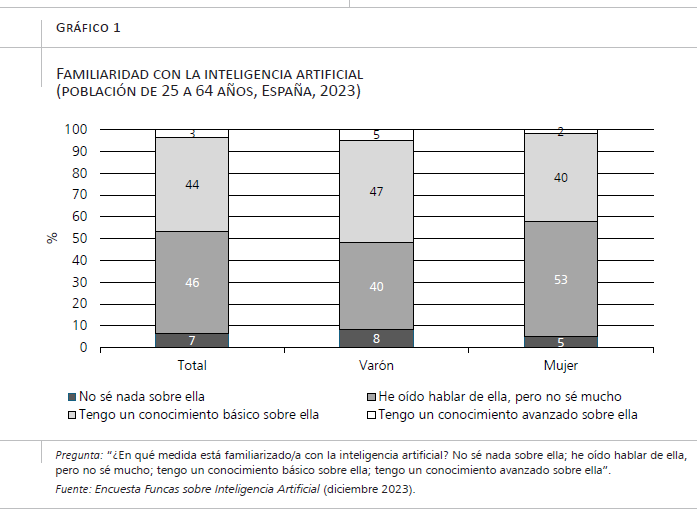

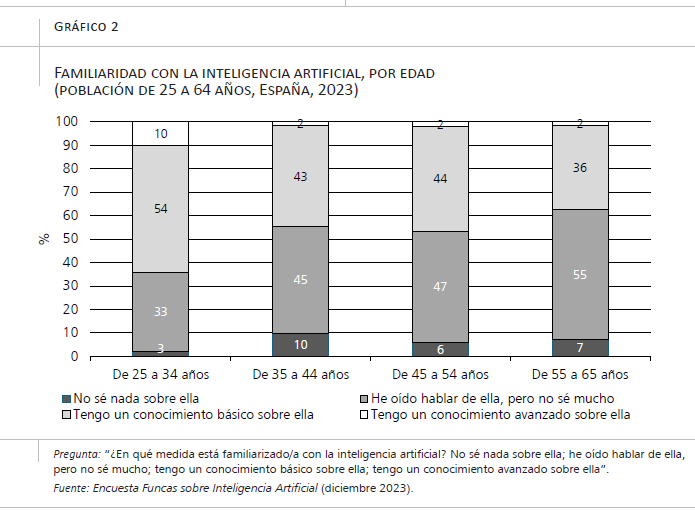

En este apartado se presentan algunas pautas relevantes sobre el conocimiento y uso de la IA entre los participantes en la Encuesta Funcas sobre Inteligencia Artificial, realizada en diciembre de 2023 a una muestra de 1.000 personas. De los resultados de la encuesta se desprende, en primer lugar, que tanto el conocimiento (autopercibido) como el uso de esta tecnología es escaso. Ante la pregunta sobre grado de familiaridad con la IA, la mayoría de los encuestados (53 por ciento) declaró tener un conocimiento limitado o nulo (no saber nada sobre ella o haber oído hablar, pero no saber mucho). Un 44 por ciento reconoció un conocimiento básico, y muy pocos (3 por ciento) manifestaron contar con un conocimiento avanzado (gráfico 1). De forma muy notable, y como cabría esperar, la edad influye en esta percepción: entre los jóvenes de 25 a 34 años, el porcentaje de los que declaran saber poco o nada disminuye a un 36 por ciento y, de hecho, el 10 por ciento de este grupo de edad afirma tener un conocimiento avanzado (gráfico 2).

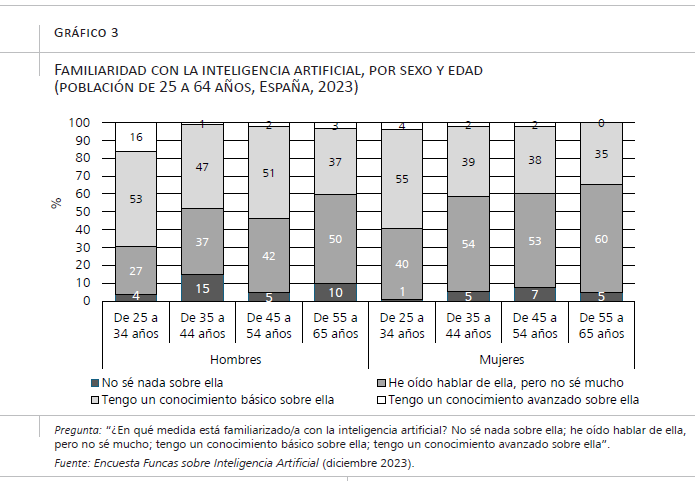

El género establece otra división clara entre los encuestados, ya puesto de relieve en otras encuestas. Las mujeres, en general, reportan un menor conocimiento sobre la IA que los hombres: un 58 por ciento declaran saber poco o nada sobre la IA, frente al 48 por ciento de los hombres (gráfico 1). Esta tendencia es consistente con estudios previos que sugieren que las mujeres tienden a subestimar sus habilidades en ciencia y tecnología, incluso cuando sus competencias son similares a las de los hombres, como señala Sainz (2024) en este mismo número. No obstante, la concentración de las diferencias entre los más jóvenes cuestiona que se pueda atribuir la brecha de género únicamente a la subestimación de las habilidades de las mujeres: el 16 por ciento de los hombres jóvenes manifiestan un conocimiento avanzado, frente al 4 por ciento de las mujeres de la misma edad. Cabe destacar que, como se verá a continuación, son precisamente los hombres jóvenes quienes muestran una mayor frecuencia de uso de la inteligencia artificial, factor positivamente relacionado con una mayor familiaridad con la tecnología.

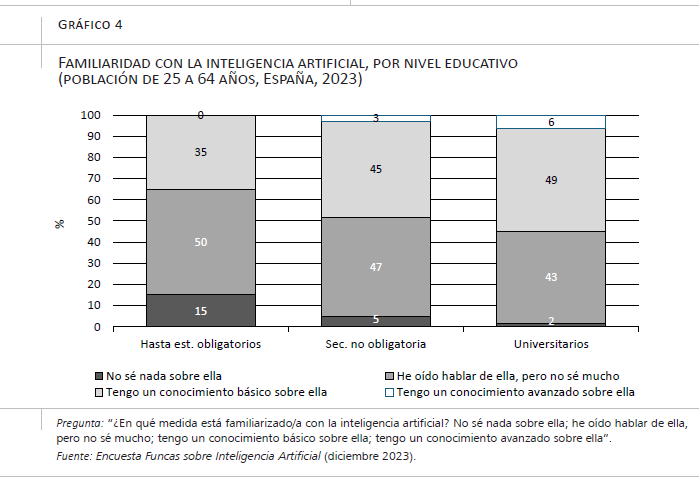

También el nivel educativo juega un papel crucial. Aquellos con educación universitaria se perciben como más informados sobre la IA: el porcentaje de los que afirman saber poco o nada sobre ella se reduce en este grupo de personas más formadas al 45 por ciento, mientras que alcanza el 65 por ciento entre los encuestados que, como máximo, han cursado educación obligatoria (gráfico 4).

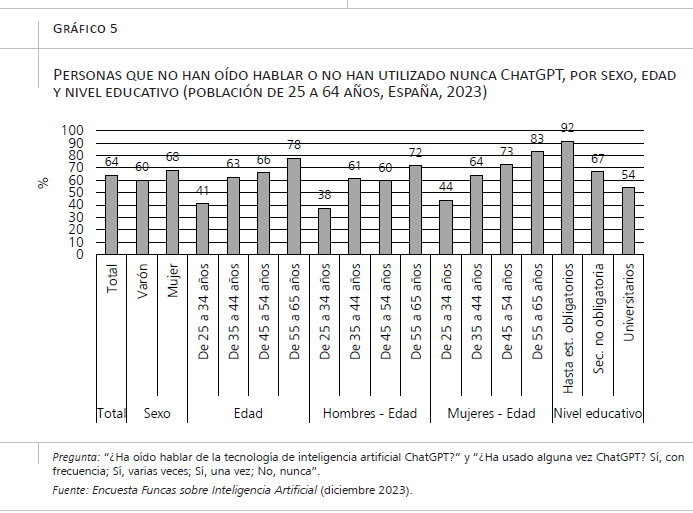

La encuesta proporciona también datos sobre el conocimiento y uso de ChatGPT, una de las herramientas que la población general conoce e identifica como basada en inteligencia artificial. Dos de cada diez encuestados no han oído nunca hablar de esta aplicación y casi dos de cada tres (64 por ciento) no lo han usado nunca (porque no hayan oído hablar de ella o porque, habiendo oído hablar, no la han usado). Aunque el 19 por ciento la han usado varias veces, solo el 4 por ciento del total de encuestados declaran usarlo con frecuencia (gráfico 5). Edad, género y nivel educativo son también variables que se relacionan con el uso de esta herramienta: jóvenes, hombres y personas con estudios universitarios declaran en mayor medida haber usado ChatGPT alguna vez y, de haberlo hecho, con una mayor frecuencia.

El uso frecuente de ChatGPT se concentra, sobre todo, entre los hombres jóvenes, aunque ni mucho menos es mayoritario. Uno de cada cinco (21 por ciento) afirma usarlo con frecuencia, mientras que entre las mujeres de la misma edad la proporción no llega a una de cada diez (8 por ciento). De hecho, un 38 por ciento de los varones jóvenes nunca ha usado ChatGPT, pero esta proporción es seis puntos mayor entre las mujeres jóvenes (44 por ciento) (gráfico 6). La distancia respecto a los mayores, en todo caso, es oceánica: el 72 por ciento de los hombres entre 55 y 64 años, y el 83 por ciento de las mujeres en ese mismo rango de edad, no han usado nunca ChatGPT. De casi la misma magnitud es la distancia entre encuestados de diferentes niveles educativos: el 56 por ciento de los universitarios no han utilizado nunca ChatGPT, pero entre las personas que como máximo han alcanzado el nivel de estudios obligatorios este porcentaje asciende al 92 por ciento.

5. Los recelos hacia la inteligencia artificial

Tal y como se ha expuesto a lo largo de este artículo, la IA no es la primera tecnología cuyos riesgos suscitan intensas preocupaciones, pero la novedad de algunos de esos riesgos y la enorme incertidumbre que generan agravan esas inquietudes. La Encuesta Funcas sobre Inteligencia Artificial ofrece evidencias sobre las expectativas que los entrevistados tienen del impacto de la IA en tres dimensiones: en su vida (en un plazo de cinco años), en el empleo (en España) y en la humanidad.

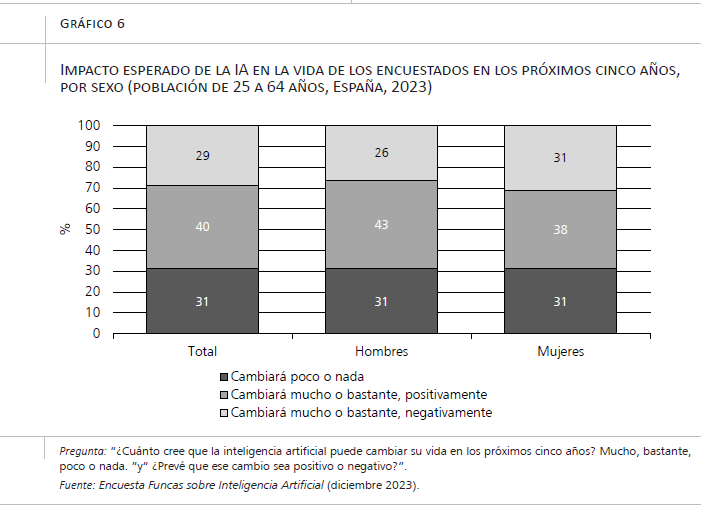

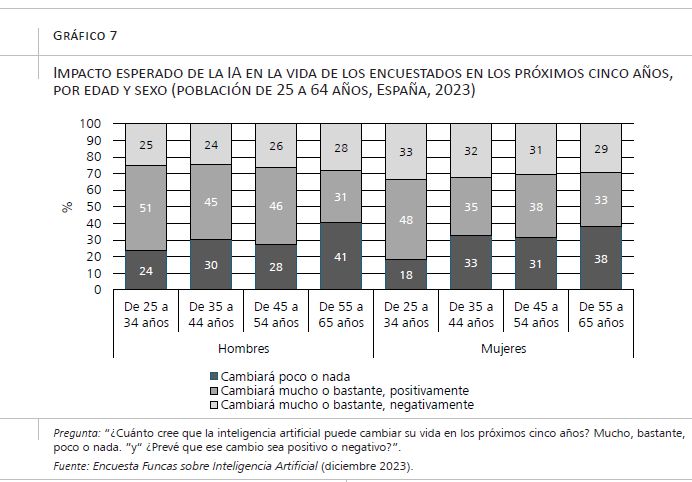

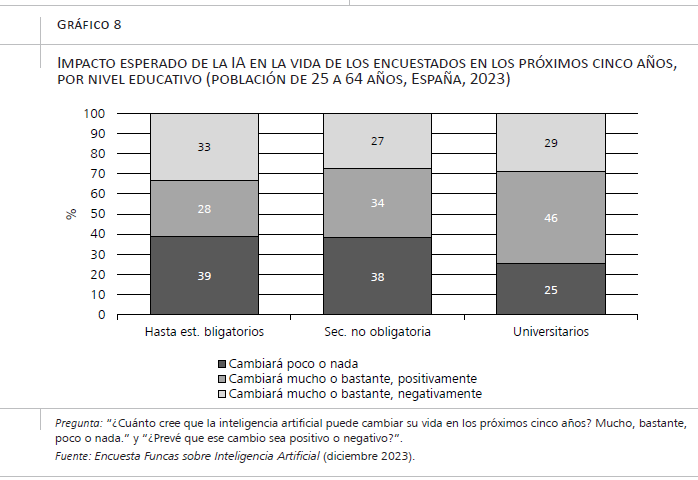

Tres de cada diez entrevistados creen que la IA tendrá poco o ningún impacto en sus vidas en el plazo de cinco años (gráfico 6). El escepticismo sobre el impacto de esta tecnología es mayor entre las personas de más edad y las que carecen de estudios universitarios, sin que los datos arrojen diferencias ostensibles entre hombres y mujeres. En cambio, más de dos tercios de los encuestados opinan que la IA puede cambiar sus vidas mucho o bastante en el medio plazo y, entre ellos, son más los que creen que el cambio será positivo que negativo. De entre el total de encuestados, cuatro de cada diez piensan que la IA cambiará sus vidas bastante o mucho de forma positiva, y tres de cada diez, que lo hará negativamente. El pesimismo sobre las consecuencias de la IA es algo mayor entre las mujeres; (gráfico 6) por el contrario, el optimismo se concentra nuevamente entre los jóvenes (tanto hombres como mujeres) (gráfico 7) y los universitarios (gráfico 8).

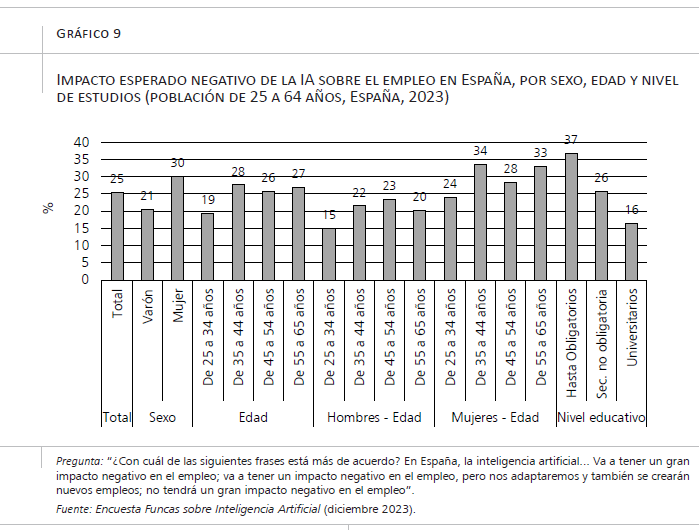

En cuanto a una de las grandes preocupaciones respecto a la IA, sus consecuencias sobre el empleo en España, el porcentaje de pesimistas es similar al del impacto esperado sobre la propia vida de los encuestados, aunque, en este aspecto, más mujeres que hombres expresan expectativas negativas (30 por ciento frente al 21 por ciento de los hombres), lo que probablemente refleja que perciben una mayor vulnerabilidad en el mercado laboral (gráfico 9). Las expectativas negativas son también menos frecuentes entre los jóvenes, especialmente los hombres jóvenes. Por último, una de las variables que se relaciona más intensamente con un impacto esperado negativo es el nivel de estudios. La diferencia entre los que han cursado como máximo estudios obligatorios y los que han completado estudios universitarios es de 20 puntos (37 por ciento entre los primeros y 16 por ciento entre los últimos).

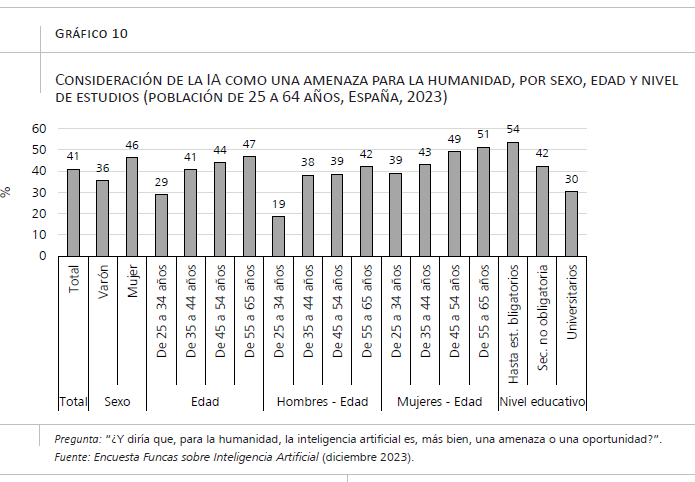

Frente a estas dos expectativas acotadas (temporalmente, la vida de los entrevistados; espacialmente, el empleo) la preocupación se intensifica al considerar una dimensión más imprecisa, aunque trascendental: la humanidad. Mientras que un 29 por ciento esperan un efecto negativo en sus vidas en un plazo de cinco años, y un 25 por ciento un efecto negativo sobre el empleo en España, el porcentaje de personas que perciben en la IA una amenaza para la humanidad asciende al 41 por ciento (gráfico 10). Las diferencias entre estas cifras sugieren que muchos sitúan esa amenaza en un horizonte temporal de largo plazo. Esta desconfianza en las consecuencias de la IA alcanza valores más elevados entre las mujeres (sobre todo, las mayores) y las personas con menor nivel educativo. Nuevamente, son los hombres jóvenes los que muestran una opinión más favorable a la IA.

Como cabría esperar, las visiones negativas sobre la IA correlacionan entre sí. Más de ocho de cada diez encuestados que anticipan cambios negativos en sus vidas o en el empleo consideran también que la IA representa una amenaza para la humanidad (87 y 82 por ciento, respectivamente). Sin embargo, muchas personas que perciben riesgos existenciales para la humanidad no temen efectos negativos más acotados. Por ejemplo, el 49 por ciento de los que creen que la IA es una amenaza para la humanidad no espera un efecto negativo en el empleo en España.

Como han señalado muchas investigaciones sobre la relación entre la sociedad y la tecnología (por ejemplo, Jermutus et al., 2022 y Yigitcanlar et al., 2023), las actitudes hacia la IA se relacionan estrechamente con la experiencia en su uso. La media del 41 por ciento de personas que consideran la IA una amenaza sube al 49 por ciento entre quienes nunca han usado ChatGPT. También el uso se relaciona con la expectativa de un impacto negativo en el empleo, que es del 12 por ciento entre los que han usado ChatGPT varias veces o de forma frecuente, pero asciende al 25 por ciento para el total de los encuestados. Es importante destacar, de todas formas, la dificultad de establecer una dirección causal en estas correlaciones. Si bien la familiaridad con la IA puede reducir la desconfianza hacia la tecnología, también es posible que las personas con menos temores sean las más propensas a explorarla y utilizarla.

6. Prioridades en la regulación de la IA y liderazgo global

La regulación de la IA es un tema de creciente importancia y debate. La dificultad de la decisión sobre si la prioridad debe ser controlar su uso o fomentar su desarrollo refleja la complejidad del equilibrio entre aprovechar los beneficios de la IA y mitigar sus riesgos. Comprender las preferencias de la sociedad en este aspecto puede contribuir a explicar las decisiones sobre las políticas sobre el desarrollo en la IA en los próximos años, toda vez que cabe esperar que los partidos políticos las tomen en cuenta, al menos hasta cierto punto.

La mayoría de los participantes en la Encuesta Funcas sobre Inteligencia Artificial muestran una clara preferencia por que la regulación se centre en controlar el desarrollo y funcionamiento de la IA en aspectos como el uso, la privacidad y la transparencia. Concretamente, cinco de cada seis encuestados (83 por ciento) creen que este debería ser el principal objetivo de la regulación comunitaria en materia de IA. Solo un 14 por ciento de los encuestados opinan que la prioridad debe ser fomentar la inversión y la innovación en IA para mantener la competitividad internacional de las economías europeas.

Esta preferencia por el control regulatorio prevalece rotundamente en todos los grupos de edad, sexo y nivel educativo, aunque es ligeramente menor entre los hombres jóvenes, grupo en el que, aun así, alcanza a dos tercios de los encuestados. Las diferencias en función del conocimiento autopercibido de la IA son mínimas, y aunque hay una variación algo mayor entre diferentes niveles de uso de ChatGPT, sigue siendo pequeña. Incluso entre aquellos que consideran la IA como una oportunidad más que como una amenaza, el 82 por ciento cree que la prioridad regulatoria debería residir en el control.

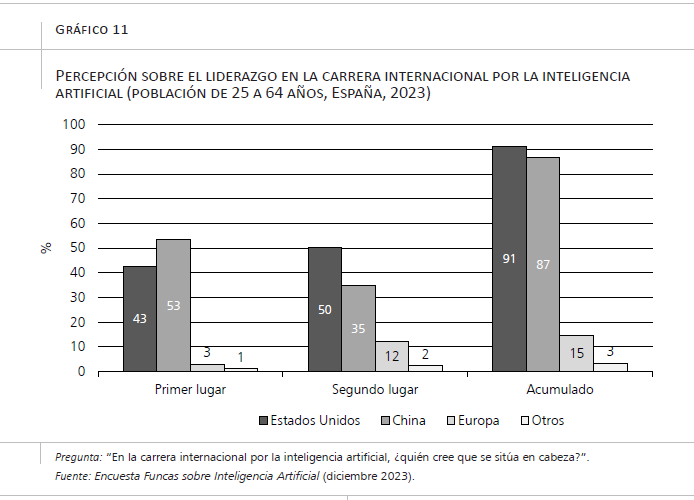

Esta clara preferencia por el control regulatorio frente al fomento de la inversión en IA contrasta con la percepción de que Europa no lidera la carrera internacional por la IA. Un 53 por ciento de los encuestados cree que Estados Unidos está a la vanguardia, mientras que el 43 por ciento piensa que China ocupa el primer lugar (gráfico 11). Solo un 3 por ciento identifica a Europa como líder en este ámbito. Incluso al considerar el segundo lugar en la carrera por la IA, apenas el 12 por ciento menciona a Europa. En total, solo uno de cada seis encuestados sitúan a Europa en primer o segundo lugar en la carrera internacional por la IA. La opinión de los encuestados no se aleja de la realidad: en 2023 Estados Unidos era el líder mundial en este campo: 61 modelos destacados de IA se originaron en instituciones con sede en EE. UU., muy por delante de la Unión Europea y China (Maslej et al., 2024). Estos datos constatan una paradoja significativa: a pesar del escaso apoyo para fomentar la inversión en IA como prioridad regulativa, existe una conciencia clara (y acertada) de que Europa no está liderando en este campo.

7. Conclusiones

El análisis de los datos de la Encuesta Funcas sobre Inteligencia Artificial revelan que, en España, el conocimiento y uso de la IA aún son limitados. Esta falta de familiaridad es más pronunciada entre las personas mayores y aquellas con menor nivel educativo. La brecha de género también es evidente: las mujeres declaran un menor conocimiento y uso que los hombres. Los hombres jóvenes constituyen el grupo que destaca por su mayor frecuencia de uso y su conocimiento avanzado, pero también por su actitud más positiva hacia la IA en cada una de las facetas exploradas en este artículo. El caso de los hombres ejemplifica, en línea con la evidencia empírica previa, que la exposición y la interacción directa con la tecnología se relacionan positivamente con la percepción y la confianza en la IA.

La preferencia por una regulación centrada en el control de la IA en beneficio de la privacidad y la transparencia es clara entre los encuestados. El predominio de esta preferencia se observa en todos los grupos demográficos, aunque es ligeramente menor entre los hombres jóvenes. Esta pauta coexiste con una conciencia general de que Europa no está liderando la carrera internacional por la IA, dominada por Estados Unidos y China. Se podría deducir que la regulación está bien alienada con las preferencias de los ciudadanos europeos, pero también, si se tiene en cuenta la rotundidad de las cifras, que el margen para elaborar una regulación que potencie la IA es reducido.

La prioridad regulatoria que expresan los encuestados se asienta sobre recelos significativos acerca de las implicaciones de la IA. Estos recelos alcanzan proporciones sustanciales, aunque no mayoritarias, de los encuestados. El hecho de que las respuestas pesimistas sobre el efecto de la IA sean más frecuentes cuando se alude a una dimensión imprecisa temporalmente, pero trascendente (la humanidad), apunta a la relevancia de los “imaginarios colectivos”. También sugiere que buena parte de la sociedad no percibe el impacto de la IA como algo concreto (personal, contextual o temporalmente), aunque ya lo es y todo indica que lo va a ser mucho más.

Bibliografía

Beets, B., Newman, T. P., Howell, E. L., Bao, L., y Yang, S. (2023). Surveying public perceptions of artificial intelligence in health care in the United States: Systematic review. Journal of Medical Internet Research, 25, e40337.

Bostrom, N. (2016). Superintelligence: Paths, Dangers, Strategies. Oxford University Press.

Brauner, P., Hick, A., Philipsen, R., y Ziefle, M. (2023). What does the public think about artificial intelligence?—A criticality map to understand bias in the public perception of AI. Frontiers in Computer Science, 5, 1113903.

Brewer, P. R., Cuddy, L., Dawson, W., y Stise, R. (2024). Artists or art thieves? Media use, media messages, and public opinion about artificial intelligence image generators. AI & SOCIETY, 2024, 1-11.

Cave, S., y Dihal, K. (2019). Hopes and fears for intelligent machines in fiction and reality. Nature Machine Intelligence, 1(2), 74–78.

Crockett, K., Garratt, M., Latham, A., Colyer, E., y Goltz, S. (2020). Risk and trust perceptions of the public of artifical intelligence applications. 2020 International Joint Conference on Neural Networks (IJCNN), 1–8.

Davis, F. D., y Granić, A. (2024). The technology acceptance model: 30 years of TAM. Springer International Publishing.

FECYT. (2023). Percepción social de la ciencia y la tecnología en España 2023. Fundación Española Ciencia y Tecnología.

Hadlington, L., Karanika-Murray, M., Slater, J., Binder, J., Gardner, S., y Knight, S. (2024). Public perceptions of the use of artificial intelligence in defence: A qualitative exploration. AI & SOCIETY, 2024, 1-14.

Jermutus, E., Kneale, D., Thomas, J., y Michie, S. (2022). Influences on user trust in healthcare artificial intelligence: A systematic review. Wellcome Open Research, 7(65), 65.

Kurzweil, R. (2006). The Singularity is near: When humans trascend biology. Penguin Publishers.

Liehner, G. L., Biermann, H., Hick, A., Brauner, P., y Ziefle, M. (2023). Perceptions, attitudes and trust towards artificial intelligence. An assessment of the public opinion. Artificial Intelligence and Social Computing, 782, 32–41.

Mao, Y., y Shi-Kupfer, K. (2023). Online public discourse on artificial intelligence and ethics in China: Context, content, and implications. AI & SOCIETY, 38(1), 373–389.

Merenkov, A. V., Campa, R., y Dronishinets, N. P. (2021). Public opinion on artificial intelligence development. KnE Social Sciences, 565–574.

Marken, S., y Nicola, T. (2023). Three in four Americans believe AI will reduce jobs. Gallup.Com. https://news.gallup.com/opinion/gallup/510635/three-four-americans-believe-reduce-jobs.aspx

Maslej, N., Fattorini, L., Perrault, R., Parli, V., Reuel, A., Brynjolfsson, E., Etchemendy, J., Ligett, K., Lyons, T., Manyika, J., Niebles, J. C., Shoham, Y., Wald, R., y Clark, J. (2024). The AI index 2024 annual report. AI Index Steering Committee, Institute for Human-Centered AI, Stanford University.

Rogers, E. M. (2004). A Prospective and Retrospective Look at the Diffusion Model. Journal of Health Communication, 9(sup1), 13–19.

Sainz, M. (2024). Estereotipos y sesgos de género en la evaluación de las propias competencias científico-tecnológicas. Panorama Social, 39.

Sánchez-Holgado, P., Calderón, C. A., y Blanco-Herrero, D. (2022). Conocimiento y actitudes de la ciudadanía española sobre el big data y la inteligencia artificial. Revista ICONO 14. Revista Científica de Comunicación y Tecnologías Emergentes, 20(1).

Sartori, L., y Bocca, G. (2023). Minding the gap(s): Public perceptions of AI and socio-technical imaginaries. AI & SOCIETY, 38(2), 443–458.

Tyson, A., y Kikuchi, E. (2023). Growing public concern about the role of artificial intelligence in daily life. Pew Research Center. https://www.pewresearch.org/short-reads/2023/08/28/growing-public-concern-about-the-role-of-artificial-intelligence-in-daily-life/

Tyson, A., Pasquini, G., Spencer, A., y Funk, C. (2023). 60% of Americans would be uncomfortable with provider relying on ai in their own health care. Pew Research Center. https://www.pewresearch.org/science/2023/02/22/60-of-americans-would-be-uncomfortable-with-provider-relying-on-ai-in-their-own-health-care/

Venkatesh, V. (2022). Adoption and use of AI tools: A research agenda grounded in UTAUT. Annals of Operations Research, 308(1–2), 641–652.

Vogels, E. A. (2023). A majority of Americans have heard of ChatGPT, but few have tried it themselves. Pew Research Center. https://www.pewresearch.org/short-reads/2023/05/24/a-majority-of-americans-have-heard-of-chatgpt-but-few-have-tried-it-themselves/

Yigitcanlar, T., Li, R., Y. M., Beeramoole, P. B., y Paz, A. (2023). Artificial intelligence in local government services: Public perceptions from Australia and Hong Kong. Government Information Quarterly, 40(3), 101833.

Zhang, B. (2022). Public opinion toward artificial intelligence. En J. B. Bullock, Y. C. Chen, J. Himmelreich, V. M. Hudson, A. Korinek, M. M. Young y B. Zhang (Eds.), The Oxford handbook of AI governance. Oxford University Press.

Zimmer, M., Franco, Z., Madiraju, P., Echeveste, C., Heindel, K., y Ogle, J. (2021). Public Opinion Research on Artificial Intelligence in Public Health Responses: Results of Focus Groups with Four Communities. Washington, DC: AAAS Center for Public Engagement with Science and Technology, 2021–09.

NOTAS

* UNED y Funcas (mmiyar@poli.uned.es).

1 La última Encuesta de Percepción Social de la Ciencia y la Tecnología en España, del FECYT, data de 2022 y su trabajo de campo se realizó antes del lanzamiento de ChatGPT en noviembre de ese año.

2 Veáse https://www.forbes.com/sites/digital-assets/2024/05/07/european-threat-to-end-to-end-encryption-would-invade-phones/